ICCV是计算机视觉领域最具影响力的顶级国际会议之一,由IEEE主办,每两年举行一次,同时被中国计算机学会(CCF)推荐为A类国际学术会议。ICCV 2025将于10月21日至23日在美国夏威夷檀香山会议中心举办。近日,我院两篇学术论文成功入选ICCV 2025,这是昆明理工大学首次在该顶级国际会议上发表研究成果,标志着我校在计算机视觉领域研究取得重要突破。学院此次录用的两篇论文分别聚焦于多模态医学图像融合、红外-可见光行人重识别方向的研究。

与此同时,学院在国际多媒体顶会ACM MM 2025上发表两篇论文。ACM MM由美国计算机协会(ACM)发起,是多媒体处理、分析与计算领域的顶级盛会,也是CCF推荐的A类国际学术会议。ACM MM 2025将于2025年10月27日至10月31日在爱尔兰都柏林举行。学院此次录用的两篇论文分别聚焦于多模态行人匹配、红外-可见光行人重识别方向的研究。

以下为四篇论文简介(排序不分先后):

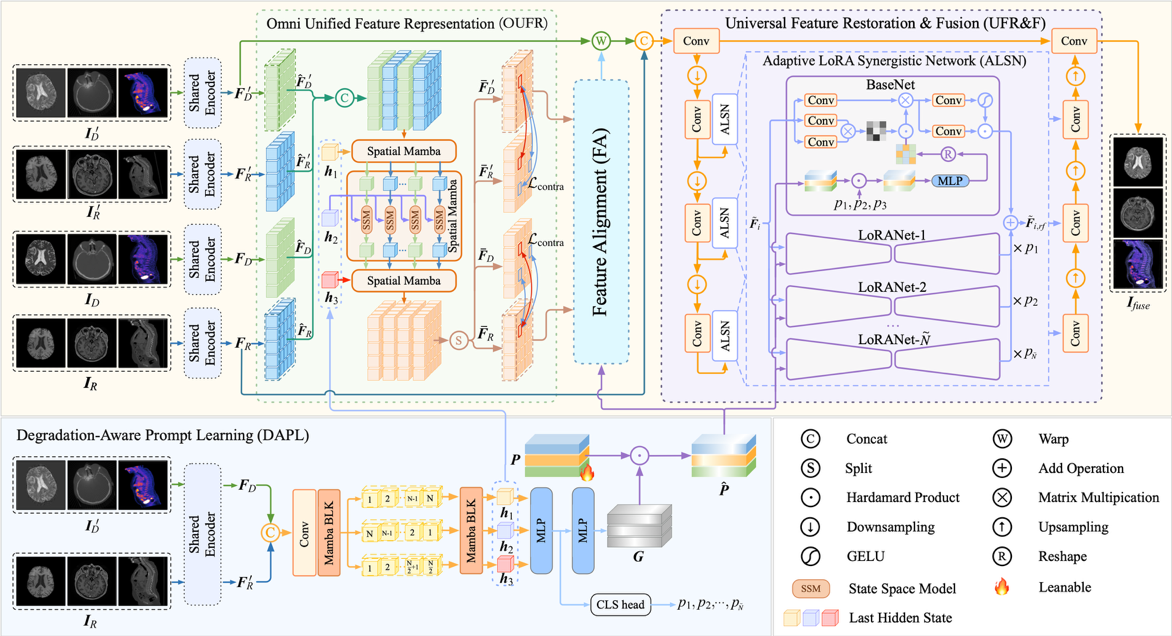

(1) 论文题目:UniFuse: A Unified All-in-One Framework for Multi-Modal Medical Image Fusion Under Diverse Degradations and Misalignments

作者:苏大勇,张亚飞,李华锋,李锦兴,刘羽

论文简介:当前的多模态医学图像融合方法通常假设源图像具有高质量并在像素级上完全对齐,其性能在很大程度上依赖于这一前提条件,在处理失配或退化图像时效果显著下降。为了解决这一问题,我们提出了一个通用融合框架——UniFuse。该框架引入了一个感知退化的提示学习模块,能够从输入图像中无缝整合多方向信息,并将跨模态对齐与图像修复任务关联起来,实现两者在统一架构下的联合优化。此外,我们设计了全向统一特征表示机制,利用Spatial Mamba对多方向特征进行编码,有效缓解模态差异带来的对齐误差。为了实现图像修复与融合的一体化处理,我们提出了通用特征修复与融合模块,并引入基于LoRA原理构建的自适应LoRA协同网络,利用其自适应特征表示能力和退化类型感知机制,在单阶段框架中实现了图像修复与融合的联合优化。与传统的分阶段方法相比,UniFuse在对齐、修复和融合方面实现了真正的一体化。多个数据集上的实验结果表明,该方法在性能上显著优于现有方案。

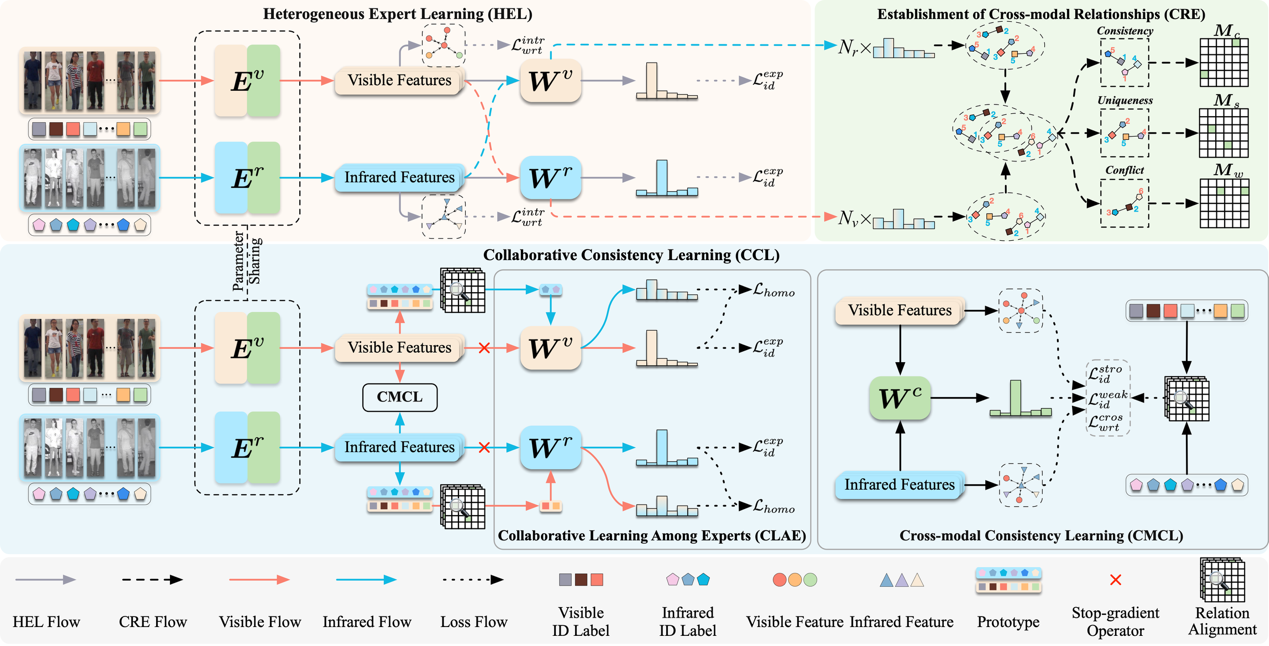

(2) 论文标题:Weakly Supervised Visible-Infrared Person Re-Identification via Heterogeneous Expert Collaborative Consistency Learning

作者:张亚飞,孔令奇,李华锋,文杰

论文简介:为了减少可见光-红外行人重识别模型对跨模态标注样本的依赖,本文提出了一种弱监督跨模态行人重识别方法,该方法仅使用单模态样本的身份标签,适用于跨模态身份标签不可用的场景。为了减轻缺失跨模态标签对模型性能的影响,本文设计了一个异质专家协同一致性学习框架,旨在以弱监督的方式建立稳健的跨模态身份关联。该框架利用各模态中的有标签数据,分别独立训练专属的分类专家。为了关联跨模态样本,这些分类专家作为异质预测器,预测来自另一模态样本的身份。为提升预测准确性,本文设计了一种跨模态关系融合机制,有效整合不同专家的预测结果。在跨模态身份关联所提供的隐式监督下,促进了各专家之间的协同一致性学习,显著增强了模型提取模态不变特征和跨模态身份识别的能力。在SYSU-MM01和LLCM两组具有挑战性的数据集上的实验结果验证了所提方法的有效性。

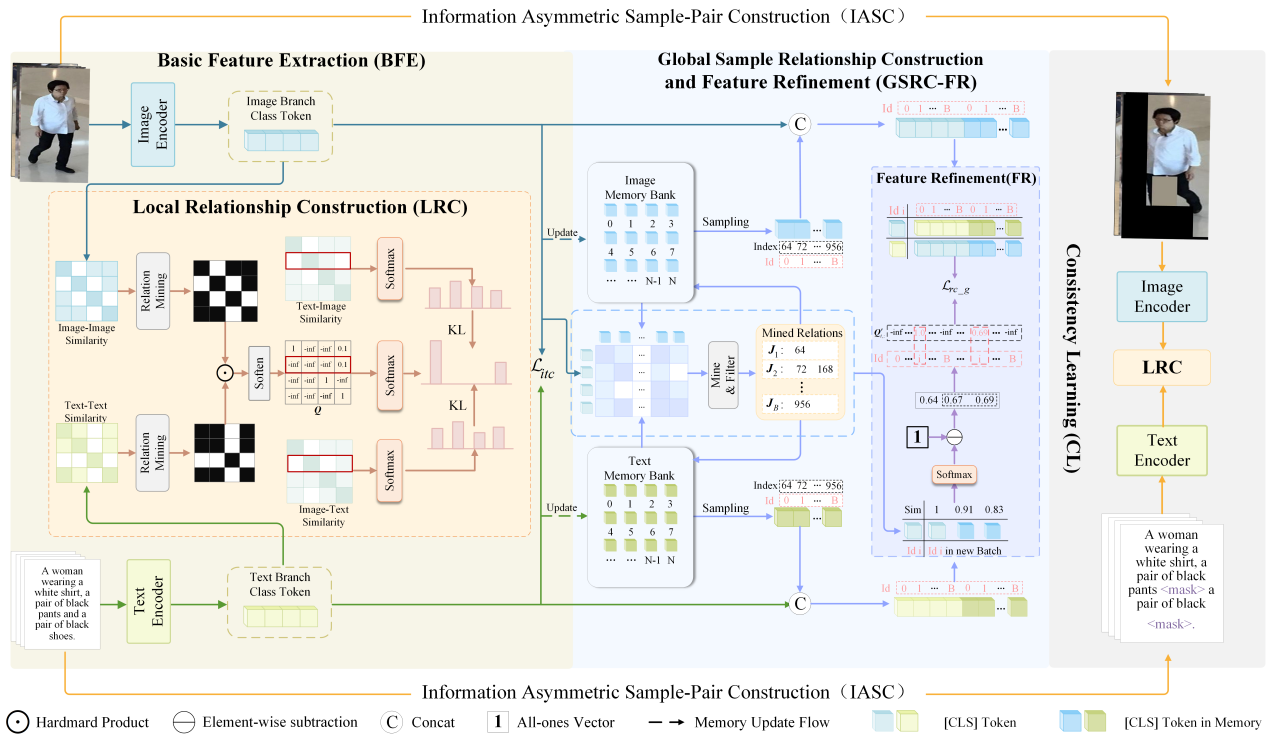

(3) 论文标题:Dual-Granularity Cross-Modal Identity Association for Weakly-Supervised Text-to-Person Image Matching

作者:张亚飞,尚永乐,李华锋

论文简介:弱监督文本到图像的行人匹配是减少模型对大规模人工标注样本依赖的重要方法,具有重要的研究价值。然而,现有方法难以预测复杂的一对多身份关系,严重限制了模型性能的提高。为了应对这一挑战,我们提出了一种局部和全局双粒度身份关联机制来克服这些瓶颈。具体来说,在局部层面,我们明确建立批次内的跨模态身份关系,加强不同模态之间的身份约束,使模型能够更好地捕捉细微差别和相关性。在全局层面,我们构建了一个以视觉模态为锚点的动态跨模态身份关联网络,并引入了一种基于置信度的动态调整机制,有效增强了模型识别弱关联样本的能力,同时提高了整体敏感度。此外,我们还提出了一种信息不对称样本对构建方法,结合一致性学习来解决难样本挖掘问题,以增强模型的鲁棒性。实验结果表明,所提出的方法大大提高了跨模态匹配的准确性,为文本到图像的行人匹配提供了高效实用的解决方案。

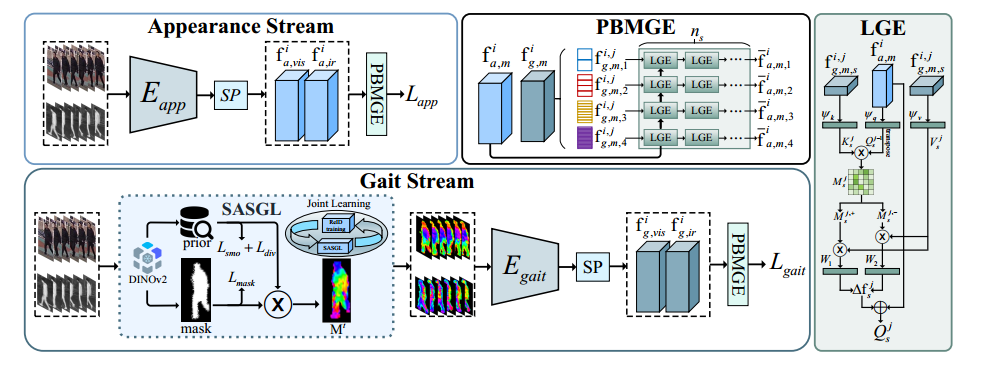

(4) 论文标题:DINOv2 Driven Gait Representation Learning for Video-Based

Visible-Infrared Person Re-identification

作者:杨宇杰,李爽,叶俊,董能,李凡,李华锋

论文简介:基于视频的可见光-红外人员重新识别(VVI-ReID)旨在从视频序列中跨可见光和红外模态检索同一行人。现有方法倾向于利用模态不变的视觉特征,但在很大程度上忽略了步态特征,这些特征不仅是模态不变的,而且具有丰富的时间动态,从而限制了它们对跨模态视频匹配至关重要的时空一致性进行建模的能力。为了应对这些挑战,我们提出了一个 DINOv2 驱动的步态表示学习(DinoGRL)框架,该框架利用 DINOv2 丰富的视觉先验来学习与外观线索互补的步态特征,从而促进跨模态检索的稳健序列级表示。具体来说,我们引入了一种语义感知轮廓和步态学习(SASGL)模型,该模型使用 DINOv2 中的通用语义先验生成和增强轮廓表示,并与 ReID 目标共同优化它们,以实现语义丰富和任务自适应步态特征学习。此外,我们开发了一个渐进式双向多粒度增强 (PBMGE) 模块,该模块通过跨多个空间粒度实现步态和外观流之间的双向交互来逐步细化特征表示,充分利用它们的互补性来增强具有丰富局部细节的全局表示并产生高度区分的特征。在 HITSZ-VCM 和 BUPT 数据集上的大量实验证明了我们方法的优越性,其明显优于现有的最先进方法。

ICCV2025网址:https://iccv.thecvf.com

ACM2025网址: https://acmmm2025.org/